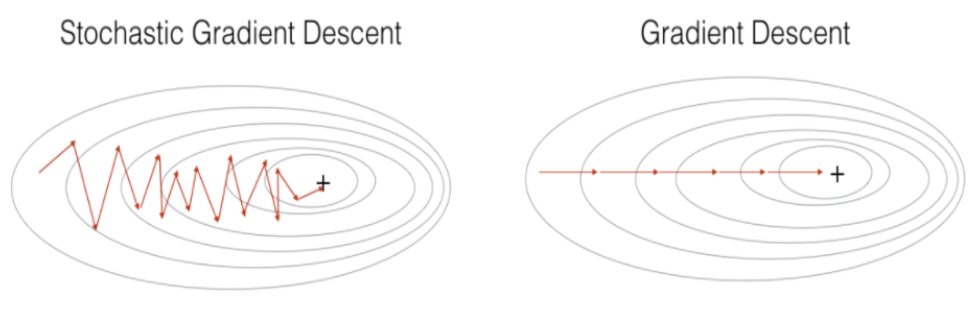

* 각각의 개념들에 대해선 다른 게시글에서 확인바랍니다 * * 이 게시글은 두 알고리즘을 비교하기 위해 만들어졌습니다 * Gradient Descent (GD) : 경사 하강법 - 1차 근삿값 발견용 최적화 알고리즘 - 기본 개념은 함수의 기울기(approximate gradient)를 구하고 경사의 반대 방향으로 계속 이동시켜 극값에 이를 때까지 반복시키는 것. Stochastic Gradient Descent (SGD) : 확률적 경사 하강법 - 학습 데이터셋에서 무작위로 한 개의 샘플 데이터 셋을 추출하고, 그 샘플에 대해서만 기울기를 계산하는 것이 특징. mini-Batch Gradient Descent (mini-BGD) : 미니 배치 경사 하강법 여기서 mini-BGD가 나오는 이유는 너무 자..