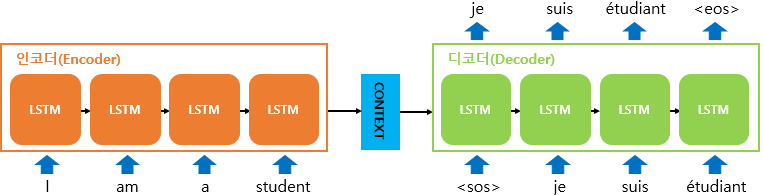

정의 Neural Machine Translation with attention 을 의역하면 다음과 같다. Sequence(input)에서 어디에 집중하여 인공신경망을 이용한 번역을 할 것인지의 관점에서 구현된 구조 Seq2Seq Architecture 간단히 Seq2Seq 구조에 대해 정리하자. 기존에 정리해놓았던 글을 인용해왔다. Seq2Seq은 시퀀스(sequence) 데이터를 다루는데 주로 사용된다. 가령, machine translation같은 작업에서 주로 사용되는데 영어를 불어로 바꾼다는 등의 task를 수행하기도 한다. 이를 위해 모델은 입력과 출력 간의 sequence mapping을 학습한다. 이 때 위에서 간단히 언급한 바와 같이 모델은 시간적인 의존성(Temporal dependen..