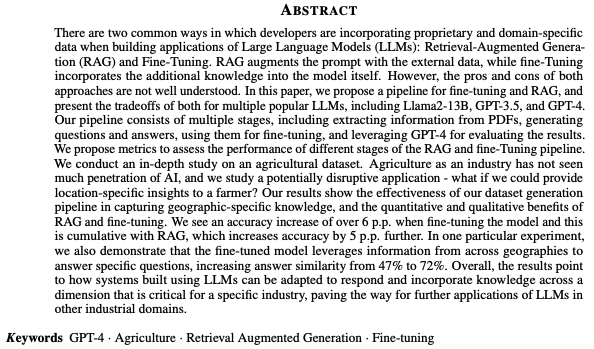

Introduction이전 포스트에서 Time Series Classification (TSC), 즉 시계열 분류에 대해 정의한 바 있습니다. 자세한 내용은 아래 링크를 통해 확인할 수 있습니다:https://24bean.tistory.com/entry/TSC-Time-series-classification-시계열-분류-정리 TSC / Time series classification 시계열 분류 정리정의 (Definition) Time Series Classification (TSC) : 시간의 흐름에 따라 측정된 데이터를 분류하는 문제를 다루는 기술. 시계열 데이터(Time Series)는 시간에 따라 값이 변화하는 데이터를 일컫는 말이다. 일24bean.tistory.com Time Series Cl..