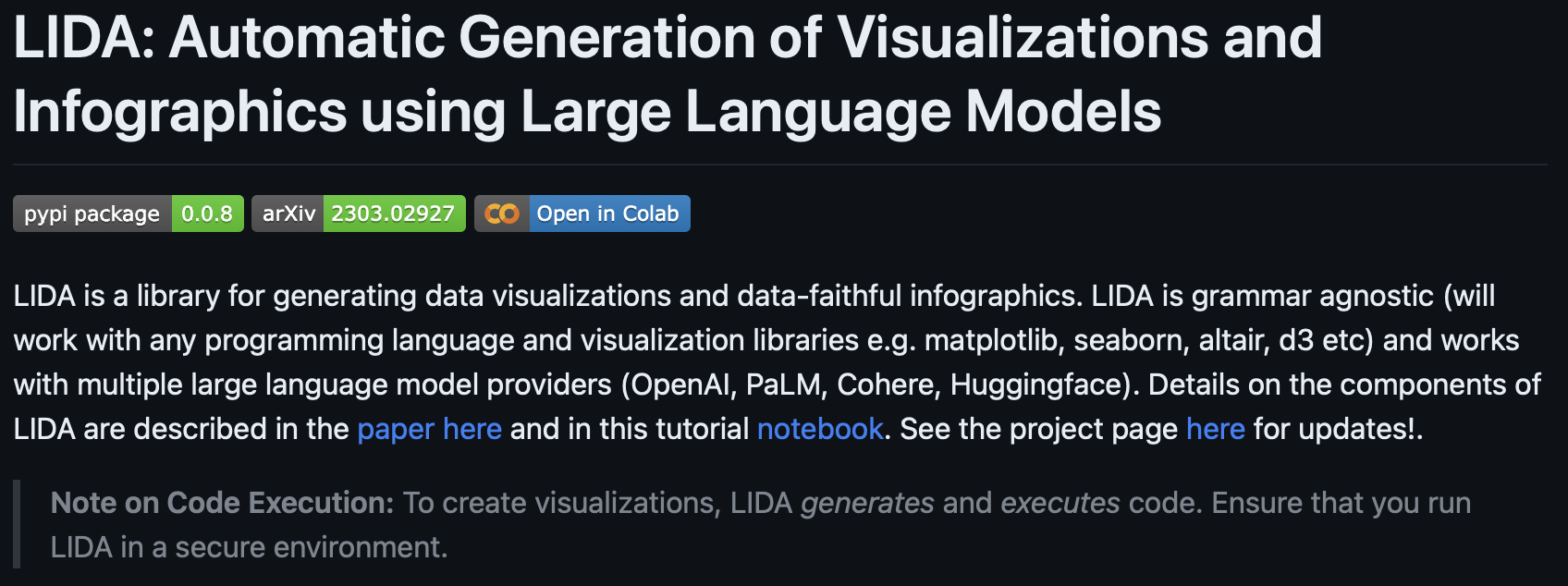

KEY TAKEAWAYS: Bard Extensions의 도입 "Google it" 버튼 도입 Bard 와의 대화 공유 및 확장 기능 추가 PaLM 2 - 최신 강화학습 기술 적용 https://bard.google.com/updates https://bard.google.com/updates bard.google.com 본문 최근 Google Bard가 업데이트를 했다는 소식이 알려졌다. 이번 업데이트에는 사용자의 편의성을 높이고 기능을 개선하는 다양한 내용이 포함되어 있다. 주요 내용은 다음과 같다. Bard Extensions: 사용자가 Bard의 기능을 사용자 지정하고 확장할 수 있는 기능이 추가되었다. "Google it" 버튼: 사용자가 Bard에게 Google 검색을 수행하도록 요청할 수 있..